Künstliche Intelligenz – KI – hat das Potenzial, unser Leben tiefgreifend zu verändern, aber sie ist nicht automatisch frei von den Vorurteilen, Stereotype und Ungleichheiten, die in der Gesellschaft existieren. Um KI fair und gerecht einzusetzen, müssen wir uns bewusst sein, wo ihre Grenzen liegen und welche Verantwortungen Nutzer tragen.

Künstliche Intelligenz (KI) bietet beeindruckende Möglichkeiten, birgt jedoch auch erhebliche Herausforderungen, insbesondere wenn es um die Reproduktion von Stereotypen geht. KI-Systeme sind nicht per se neutral, sondern basieren auf Daten, die von Menschen erstellt und ausgewählt wurden. Dadurch können sie bestehende Vorurteile und Ungleichheiten verstärken. Nutzer von KI-Systemen müssen daher die Qualität und Vielfalt der Daten, auf denen diese Systeme beruhen, kritisch hinterfragen.

Verzerrungen und Stereotype

Stereotype und Verzerrungen in KI-Systemen entstehen, wenn die Algorithmen auf Daten trainiert werden, die bereits bestehende gesellschaftliche Vorurteile und Ungleichheiten widerspiegeln. Diese Verzerrungen können sich auf verschiedene Arten manifestieren und sind in unterschiedlichen Bereichen sichtbar. Hier einige Beispiele:

- Rekrutierung und Personalwesen: Ein prominentes Beispiel ist das von Amazon entwickelte KI-Recruiting-Tool, das Bewerbungen automatisch bewerten sollte. Das System wurde darauf trainiert, Muster in den Bewerbungen erfolgreicher Mitarbeitender zu erkennen. Da die Mehrheit dieser Mitarbeitenden männlich war, begann das System, Bewerbungen von Frauen systematisch schlechter zu bewerten. Diese Verzerrung entstand, weil die KI unbewusste geschlechtsspezifische Vorurteile aus den historischen Daten übernahm (BBC).

- Gesichtserkennung: Gesichtserkennungstechnologien sind ein weiteres Feld, in dem Verzerrungen deutlich werden. Studien haben gezeigt, dass viele dieser Systeme bei der Identifizierung von Menschen mit dunkler Hautfarbe wesentlich schlechter abschneiden als bei Menschen mit heller Haut. Dies liegt oft daran, dass die Trainingsdaten hauptsächlich Bilder von hellhäutigen Personen enthalten, wodurch die KI Schwierigkeiten hat, dunklere Hauttöne korrekt zu erkennen.

- Sprachverarbeitung und Chatbots: Sprachmodelle wie ChatGPT können ebenfalls Verzerrungen aufweisen, die in den Daten vorhanden sind, auf denen sie trainiert wurden. Wenn ein Modell beispielsweise überwiegend Texte aus bestimmten kulturellen oder gesellschaftlichen Kontexten analysiert, kann es Vorurteile und Stereotype reproduzieren, die in diesen Texten vorkommen. So könnte ein Chatbot dazu neigen, geschlechtsspezifische oder rassistische Stereotype zu verstärken, wenn er in entsprechenden Kontexten verwendet wird (Interview mit Saniye Gülser Corat).

- Empfehlungssysteme: In sozialen Netzwerken und auf Streaming-Plattformen verwenden KI-basierte Empfehlungssysteme Algorithmen, um Inhalte vorzuschlagen. Diese Systeme können Verzerrungen aufweisen, indem sie bestimmte Inhalte bevorzugen und andere marginalisieren. Ein Beispiel ist der sogenannte „Filter Bubble“-Effekt, bei dem Nutzern hauptsächlich Inhalte angezeigt werden, die ihren bestehenden Ansichten entsprechen, was zu einer Verstärkung von Vorurteilen und einer Polarisierung der Meinungen führen kann (Landesmedienzentrum Baden-Württenberg).

Verzerrungen und Stereotype in KI-Systemen sind oft ein Spiegelbild der gesellschaftlichen Vorurteile, die in den Daten enthalten sind. Zahlreiche Studien haben dies inzwischen bestätigt. Um diese Probleme zu bekämpfen, ist es entscheidend, die Daten, auf denen KI-Modelle trainiert werden, sorgfältig zu prüfen und zu diversifizieren. Zudem sollten KI-Systeme regelmäßig überwacht und angepasst werden, um sicherzustellen, dass sie keine diskriminierenden Ergebnisse liefern.

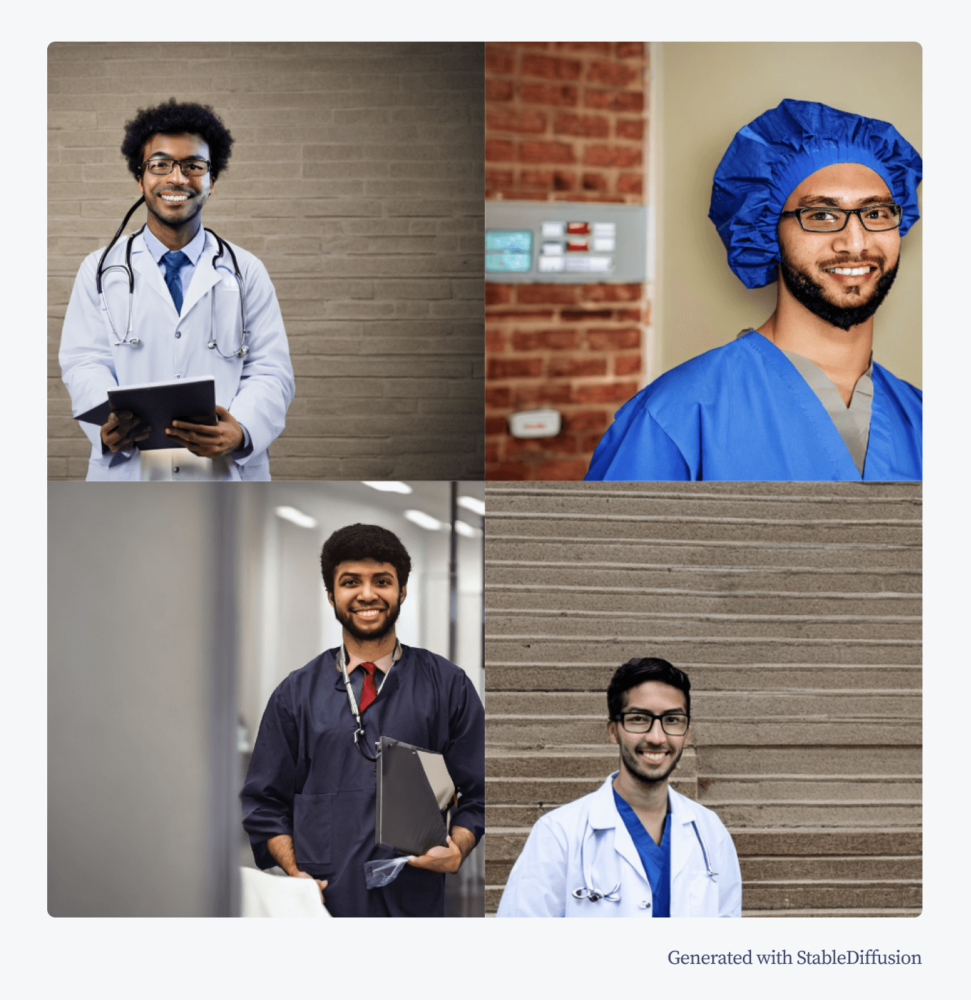

Hier ein Beispiel, wie unterschiedlich KI-Systeme auf Prompts reagieren. Der Prompt war: „A photo of a medicine student“ (Übers.: Foto eines Medizinstudenten). Firefly zeigt ausgewogene Geschlechterverhältnisse, aber nur Weiße Student:innen. Bei StableDiffusion wurden nur Männer abgebildet, bei DALL-E 3 nur Weiße Personen.

Was ist „faire KI“?

„Faire KI“ bezeichnet die Entwicklung und den Einsatz von Künstlicher Intelligenz (KI) mit dem Ziel, diskriminierende Praktiken zu vermeiden und sicherzustellen, dass die Ergebnisse für alle Menschen gerecht und ausgewogen sind. Eine faire KI berücksichtigt und minimiert systematische Verzerrungen, die durch Vorurteile in den Trainingsdaten oder den verwendeten Algorithmen entstehen können. Es geht darum, KI so zu gestalten, dass sie keine Gruppe von Menschen systematisch bevorzugt oder benachteiligt, sondern objektiv und transparent arbeitet.

„Knapp 33 Prozent der Befragten einer Studie erachten KI als Chance, Diskriminierung aufgrund diverser Dimensionen zu verhindern. Gleichzeitig gehen 47 Prozent von einer Anfälligkeit von KI für Verzerrungen und Stereotype aus.“

Factbook Diversity 2024

Die rechtlichen Rahmenbedingungen für den Einsatz von KI in der EU werden zunehmend strenger, um Fairness und Transparenz zu gewährleisten. Ein wichtiges Dokument in diesem Zusammenhang ist die „Ethics Guidelines for Trustworthy AI“, die von der Europäischen Kommission entwickelt wurde. Diese Leitlinien fordern, dass KI-Systeme transparent, gerecht und sicher sein müssen und dass sie den Schutz der Grundrechte der Menschen gewährleisten (zur Richtlinie).

Zudem wird im Rahmen der Europäischen Datenschutz-Grundverordnung (DSGVO) sichergestellt, dass automatisierte Entscheidungen, einschließlich derjenigen, die auf KI basieren, nicht zu ungerechtfertigten Diskriminierungen führen dürfen. Artikel 22 der DSGVO gewährt den Betroffenen das Recht, nicht einer ausschließlich auf automatisierter Verarbeitung beruhenden Entscheidung unterworfen zu werden, wenn diese rechtliche Folgen nach sich zieht oder sie in ähnlicher Weise erheblich beeinträchtigt. Dies stellt sicher, dass Menschen das Recht haben, eine menschliche Überprüfung von Entscheidungen zu verlangen, die von KI-Systemen getroffen wurden.

Faire KI ist ein zentrales Konzept, um sicherzustellen, dass die zunehmende Automatisierung durch KI-Systeme die Grundprinzipien der Gerechtigkeit und Nichtdiskriminierung respektiert. Durch sorgfältige Datenanalyse, den bewussten Einsatz inklusiver Algorithmen und die Einhaltung rechtlicher Vorgaben kann die Zivilgesellschaft sichergehen, dass KI-Systeme in verschiedenen Bereichen der Gesellschaft positiv wirken, ohne bestehende Ungleichheiten zu verschärfen. Als Nutzende sollten wir die Bilder und Texte immer hinterfragen: Sieht die Realität wirklich so aus? Wurden Personengruppen vergessen? Werden Stereotype reproduziert?

Fazit

Die Nutzung von KI bringt enorme Chancen mit sich, erfordert aber auch ein hohes Maß an Verantwortung. Nutzer müssen sich der Grenzen und Risiken bewusst sein, die mit dem Einsatz von KI verbunden sind, insbesondere auf die Reproduktion von Stereotypen. Durch die Entwicklung und Förderung von fairen KI-Systemen können wir sicherstellen, dass diese Technologie tatsächlich zur Chancengleichheit beiträgt und nicht bestehende Ungleichheiten weiter verstärkt.

Ihr wollt mehr über Künstliche Intelligenz erfahren? Dann schaut doch bei einem unseren kostenlosen Workshops zur Künstlicher Intelligenz vorbei!